필자는 현재 백엔드 개발자로 일하고 있지만, 데이터 엔지니어라는 목표를 마음 한편에 두고 있다.

백엔드 개발 역시 그 목표로 가는 하나의 과정이라고 생각하고 있다.

학부생 시절부터 데이터 엔지니어링 이라는 필드에 자연스레 관심이 갔다.

점차 많아지는 데이터와 LLM의 발전에 따라서 대규모 데이터를 안정성 있고 효율적으로 설계, 운영하는 일이 반드시 필요하다고 생각했고, 또 그런 일을 하는 사람을 동경하게 된 것 같다.

사실 지금도 비슷한 일을 하고 있기는 하다.

지금 나의 주요한 임무는 배치, 준실시간 ETL 서비스 개발이다.

정형, 비정형 데이터를 모두 다뤄볼 수 있는 환경이기도 하고 안정성을 최우선시해야하기 때문에 DB 부하, 이중화 구성, 장애 대응, 네트워크와 같은 인프라 측면에서도 항상 고려가 필요하다.

시스템 설계부터 타 시스템에 대한 영향도까지 고려해야 한다는 점에서 시야는 많이 넓어졌지만,

폐쇄망과 레거시 환경이라는 점이 현대적인 데이터 엔지니어링과 격차로 느껴져 항상 아쉬움이 남게 되었다.

그래서 필자는 호기심으로 카카오톡의 한국 데이터 엔지니어링 모임 이라는 오픈 채팅방에 들어가게 되었다.

들어가게 된지는 꽤 되었지만, 채팅방에서는 한마디도 하지 않았다.

앞서 말했다시피 커뮤니티에서 가장 뜨겁게 의견이 오가는 부분은 내가 알고 있는 부분과 많이 달랐기 때문이다.

그래도 앞서 길을 가시고 있는 분들의 대화를 양분 삼고, 키워드를 주워가며(?) 이래저래 공부는 해보고 있었다.

하지만 배움의 가장 효율적인 방법이 무엇인가.

백문이 불여일견, 뭐든 직접 해봐야 알게 된다.

그 첫번째 발걸음은 'Korea Data Engineering Group Meetup with ClickHouse & Kakao' 였다.

지난번 Snowflake World Tour 에 참석해본 경험으로 인사이트를 얻기에 좋은 기회라고 생각이 되었고,

항상 채팅방에서 화두에 오르던 Clickhouse Database가 궁금했다.

Meetup 은 2026-01-29 (목) 에 진행되었고, 회사 퇴근하고 강남역으로 달려갔다.

Clickhouse 측에서 맛있는 도시락도 준비해주셔서 감사했다.. (참가비 없었음..)

강연장에 도착하니, 사람이 정말 많았다.. 자리가 없어서 깜짝 놀람

그리고 다들 맥북 쓰셔서 2차 깜짝 놀람

레거시.net 개발자는 이런 풍경이 낯섭니다..

강연을 들으면서 느낀건, Snowflake 같은 SaaS 기반 분석형 DB와, ClickHouse처럼 집계 · 분석에 특화된 DB 솔루션 쪽 트렌드를 확실하게 알 수 있었다.

LLM을 적극적으로 활용하되, 결과 데이터만큼은 일관성과 재현성을 보장하는 쪽으로 설계하려는 트렌드처럼 느껴졌다.

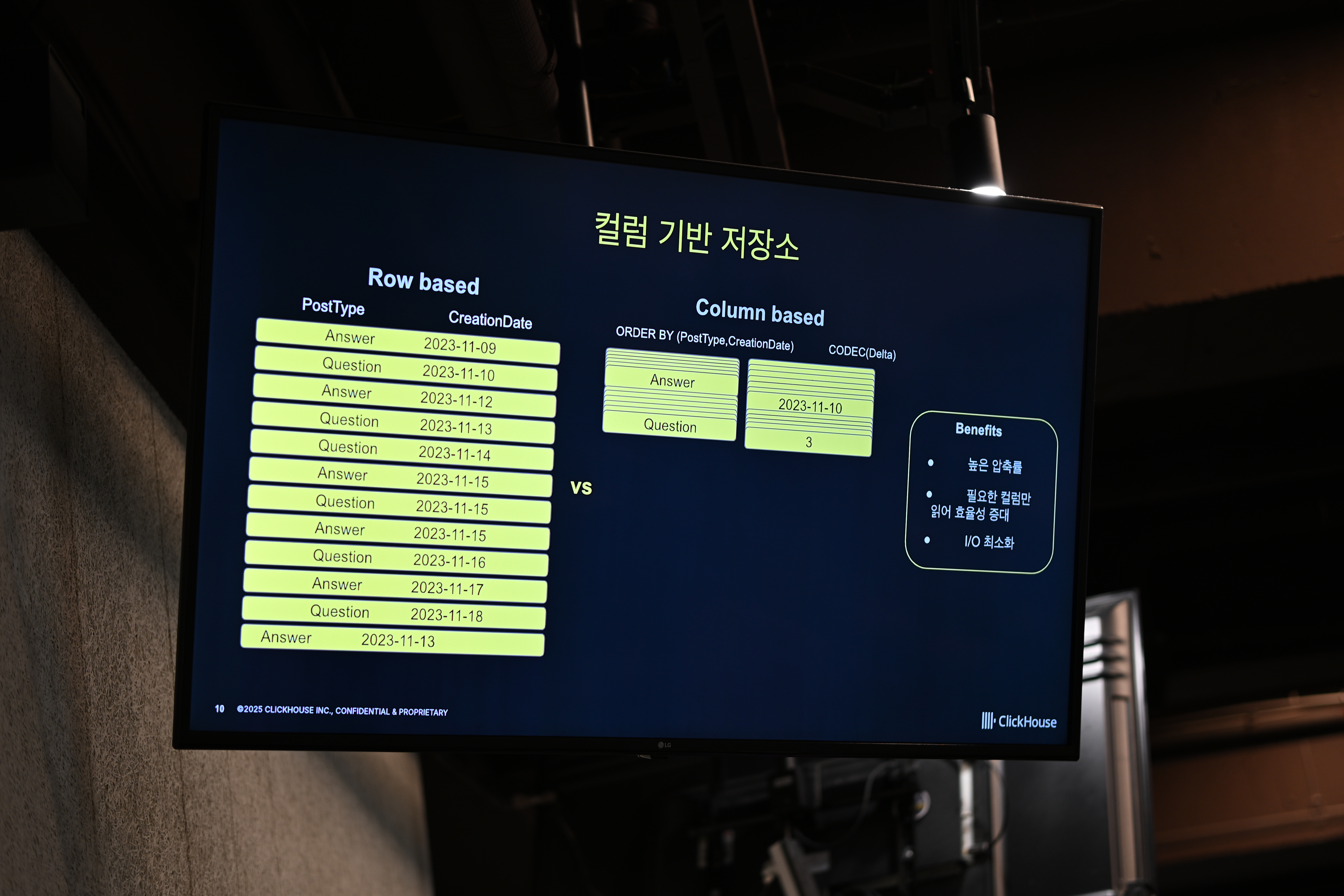

다만, 조금 색달랐던 점은 Clickhouse는 "Column 기반 데이터베이스" 인 부분이 인상적이었다.

전통 RDB는 row 단위로 저장하는데, Column 기반이 무슨 말이지..

사실 이 바탕에 대한 기본적인 이해가 부족해서 강연 내내 온전히 따라갈 수는 없었지만,

컬럼 기반 DB가 일반적인 검색보다는 대량 데이터에 대한 집계 작업에 유리하다는 점을 장점으로 설명하셔서, 개인적으로 굉장한 흥미가 생겼다.

대규모 데이터 마이그레이션을 하면서 느낀건데, 진행 상황을 보려고 group by 하면 생각보다 꽤 걸렸다.. (인덱스를 태워도 말이죠)

무튼, 몇가지 Clickhouse 에 대한 설명을 들으며 궁금했던 내용을 정리하자면

- row 기반 전통 RDB 에서 Clickhouse 로의 어떻게 복제/적재 하는 지?

- 어떤 상황에서 집계가 유리한건지?

- 벡터 인덱스의 개념이 무엇인지?

궁금한 것과 모르는 용어가 참 많았다.

하지만 궁금한 것이 생겼다는게 오늘의 밋업을 유의미하게 만들었다고 생각한다.

다음 토픽으로는 카카오에서의 Clickhouse 도입기였다.

인상적이었던 부분은 카카오의 모든 서비스의 Telemetry Data를 Clickhouse 에 저장하며,

하루에 8TB 에 가까이 되는 데이터를 적재하고 모니터링한다고 한다.

초대규모 환경에서 Clickhouse 도입에 앞서 Poc를 정말 세심하게 진행했을텐데, 채택되었다면 안정성과 성능은 보장이 되어있다고 본다. (물론 버그나 장애가 없었던 건 아니라고 한다.. ㅋㅋ)

나도 로컬에서 테스트해보고 싶다는 생각이 들었다.

정리하면서,

설명해주셨던 모든 내용에 대해서 완벽히 이해하지는 못했지만, 많은 인사이트를 얻어갈 수 있었던 것 같다.

앞으로 가야 할 길이 멀지만, 조금 느려도 꾸준히 따라가다보면 언젠간 내가 그들과 같은 고민을 하고 있진 않을까?